久々に PostgreSQL 本体機能へのパッチを投げたので、それの解説をしてみる。

PostgreSQL: Re: Asymmetric partition-wise JOIN

背景:Partition-wise JOIN

PostgreSQLのパーティションを使ったときに、全く同一のパーティションの切り方をして、かつパーティションキーをJOINの結合条件に用いた場合に限り、パーティション子テーブル同士のJOINを先に行い、その結果を出力するという機能がある。

以下の例では、ptableおよびstableは、それぞれ列distの値を用いたHashパーティションを設定しており、3つずつの子テーブルを持つ。

postgres=# \d

List of relations

Schema | Name | Type | Owner

--------+-----------+-------------------+--------

public | ptable | partitioned table | kaigai

public | ptable_p0 | table | kaigai

public | ptable_p1 | table | kaigai

public | ptable_p2 | table | kaigai

public | stable | partitioned table | kaigai

public | stable_p0 | table | kaigai

public | stable_p1 | table | kaigai

public | stable_p2 | table | kaigai

(8 rows)これをJOINする時の実行計画は以下の通り。

postgres=# explain select * from ptable p, stable s where p.dist = s.dist;

QUERY PLAN

------------------------------------------------------------------------------------

Hash Join (cost=360.00..24617.00 rows=10000 width=49)

Hash Cond: (p.dist = s.dist)

-> Append (cost=0.00..20407.00 rows=1000000 width=12)

-> Seq Scan on ptable_p0 p (cost=0.00..5134.63 rows=333263 width=12)

-> Seq Scan on ptable_p1 p_1 (cost=0.00..5137.97 rows=333497 width=12)

-> Seq Scan on ptable_p2 p_2 (cost=0.00..5134.40 rows=333240 width=12)

-> Hash (cost=235.00..235.00 rows=10000 width=37)

-> Append (cost=0.00..235.00 rows=10000 width=37)

-> Seq Scan on stable_p0 s (cost=0.00..60.77 rows=3277 width=37)

-> Seq Scan on stable_p1 s_1 (cost=0.00..62.69 rows=3369 width=37)

-> Seq Scan on stable_p2 s_2 (cost=0.00..61.54 rows=3354 width=37)

(11 rows)おっとっと。

この場合、ptableパーティションの子テーブル3つと、stableパーティションの子テーブル3つをそれぞれ全て読み出し、メモリ上で結合した結果同士をHash Joinで結合する事がわかる。

Partition-wise JOINはデフォルトでは off になっているので、enable_partitionwise_joinパラメータをonにセットして明示的に有効化する必要がある。

postgres=# set enable_partitionwise_join = on;

SET

postgres=# explain select * from ptable p, stable s where p.dist = s.dist;

QUERY PLAN

------------------------------------------------------------------------------------

Append (cost=101.73..19617.00 rows=10000 width=49)

-> Hash Join (cost=101.73..6518.87 rows=3277 width=49)

Hash Cond: (p.dist = s.dist)

-> Seq Scan on ptable_p0 p (cost=0.00..5134.63 rows=333263 width=12)

-> Hash (cost=60.77..60.77 rows=3277 width=37)

-> Seq Scan on stable_p0 s (cost=0.00..60.77 rows=3277 width=37)

-> Hash Join (cost=104.80..6527.08 rows=3369 width=49)

Hash Cond: (p_1.dist = s_1.dist)

-> Seq Scan on ptable_p1 p_1 (cost=0.00..5137.97 rows=333497 width=12)

-> Hash (cost=62.69..62.69 rows=3369 width=37)

-> Seq Scan on stable_p1 s_1 (cost=0.00..62.69 rows=3369 width=37)

-> Hash Join (cost=103.47..6521.06 rows=3354 width=49)

Hash Cond: (p_2.dist = s_2.dist)

-> Seq Scan on ptable_p2 p_2 (cost=0.00..5134.40 rows=333240 width=12)

-> Hash (cost=61.54..61.54 rows=3354 width=37)

-> Seq Scan on stable_p2 s_2 (cost=0.00..61.54 rows=3354 width=37)

(16 rows)同じクエリに対して、set enable_partitionwise_join = onを設定した状態で実行計画を作らせると、対応するパーティションの子テーブル同士でJOINを行い、その次にAppend、つまり各パーティション子要素の処理結果を結合している事が分かる。

これはJOINの問題サイズを小さくし、多くの場合、Append処理に要するCPUサイクルを減らすことのできる優れた最適化テクニックではあるが、かなりの慎重さを以ってDB設計を行う必要がある。

なぜなら『全く同一のパーティションの切り方をして、かつパーティションキーをJOINの結合条件に用いる』事ができるよう、パーティション設計とSQLクエリの書き方を考える必要があるからである。

新機能:Asymmetric Partition-wise JOIN

同じようなノリで、非パーティションテーブルとパーティションテーブルの間のJOIN処理を、Appendの前に移動する事ができる。

例えば、非パーティションテーブルであるt1とptableとの間のJOINをと記述すると、これは

と展開する事ができる。

言い換えれば、t1を各パーティション子テーブルに分配する(クエリの書き換えに相当)事で、Appendよりも先にJOINを実行する事ができる。

もちろん、メリット・デメリットはあるので、先にパーティション子テーブルの内容を全て読み出した後でJOINを実行した方が良いというケースもある。

具体的に Asymmetric Partition-wise JOIN が活きてくるケースというのは

- 非パーティション側のテーブルが、読み出しコストを無視できる程度に小さい。

- 分配された分、複数回の読み出しが必要となってしまうため。

- 子テーブルとのJOINにより、かなりの比率で行数が減ることが見込まれる。

- 行数が減らなければ、Append処理は楽にならない。

というケースなので、あらゆる場合で効果があるかというと、そのような銀の弾丸はない。

では試してみることにする。

本来、以下のような実行計画となったいたクエリであるが・・・

postgres=# explain select * from ptable p, t1 where p.a = t1.aid;

QUERY PLAN

----------------------------------------------------------------------------------

Hash Join (cost=2.12..24658.62 rows=49950 width=49)

Hash Cond: (p.a = t1.aid)

-> Append (cost=0.00..20407.00 rows=1000000 width=12)

-> Seq Scan on ptable_p0 p (cost=0.00..5134.63 rows=333263 width=12)

-> Seq Scan on ptable_p1 p_1 (cost=0.00..5137.97 rows=333497 width=12)

-> Seq Scan on ptable_p2 p_2 (cost=0.00..5134.40 rows=333240 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

(8 rows)同様に enable_partitionwise_join パラメータによって当該機能は有効化され、以下のような『賢い』実行計画を生成するようになる。

postgres=# explain select * from ptable p, t1 where p.a = t1.aid;

QUERY PLAN

----------------------------------------------------------------------------------

Append (cost=2.12..19912.62 rows=49950 width=49)

-> Hash Join (cost=2.12..6552.96 rows=16647 width=49)

Hash Cond: (p.a = t1.aid)

-> Seq Scan on ptable_p0 p (cost=0.00..5134.63 rows=333263 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

-> Hash Join (cost=2.12..6557.29 rows=16658 width=49)

Hash Cond: (p_1.a = t1.aid)

-> Seq Scan on ptable_p1 p_1 (cost=0.00..5137.97 rows=333497 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

-> Hash Join (cost=2.12..6552.62 rows=16645 width=49)

Hash Cond: (p_2.a = t1.aid)

-> Seq Scan on ptable_p2 p_2 (cost=0.00..5134.40 rows=333240 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

(16 rows)t1テーブルが各パーティション子テーブル毎に読み出され、その結果を Append によって結合している事がお分かりだろうか。

しかも、最初のケースでは Append は 100万行を処理しなければならないところ、後者ではHash Joinによって大幅に行数が削られているため、たった49950行(推定値)しか処理しない事になっている。これに伴う推定コストの低下によって、Asymmetric Partition-wise JOINを使った実行計画が選択された。

ちなみに、結合すべきテーブルを増やしても、(コスト的に見合えば)各パーティション子テーブルへと分配してくれる。

postgres=# explain select * from ptable p, t1, t2 where p.a = t1.aid and p.b = t2.bid;

QUERY PLAN

----------------------------------------------------------------------------------------

Append (cost=4.25..19893.99 rows=2495 width=86)

-> Hash Join (cost=4.25..6625.83 rows=832 width=86)

Hash Cond: (p.b = t2.bid)

-> Hash Join (cost=2.12..6552.96 rows=16647 width=49)

Hash Cond: (p.a = t1.aid)

-> Seq Scan on ptable_p0 p (cost=0.00..5134.63 rows=333263 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t2 (cost=0.00..1.50 rows=50 width=37)

-> Hash Join (cost=4.25..6630.20 rows=832 width=86)

Hash Cond: (p_1.b = t2.bid)

-> Hash Join (cost=2.12..6557.29 rows=16658 width=49)

Hash Cond: (p_1.a = t1.aid)

-> Seq Scan on ptable_p1 p_1 (cost=0.00..5137.97 rows=333497 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t2 (cost=0.00..1.50 rows=50 width=37)

-> Hash Join (cost=4.25..6625.48 rows=831 width=86)

Hash Cond: (p_2.b = t2.bid)

-> Hash Join (cost=2.12..6552.62 rows=16645 width=49)

Hash Cond: (p_2.a = t1.aid)

-> Seq Scan on ptable_p2 p_2 (cost=0.00..5134.40 rows=333240 width=12)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t1 (cost=0.00..1.50 rows=50 width=37)

-> Hash (cost=1.50..1.50 rows=50 width=37)

-> Seq Scan on t2 (cost=0.00..1.50 rows=50 width=37)

(28 rows)

PG-Stromとの関連

この機能は、もちろんピュアなPostgreSQLで大量データを扱うときに効果を発揮するものである。

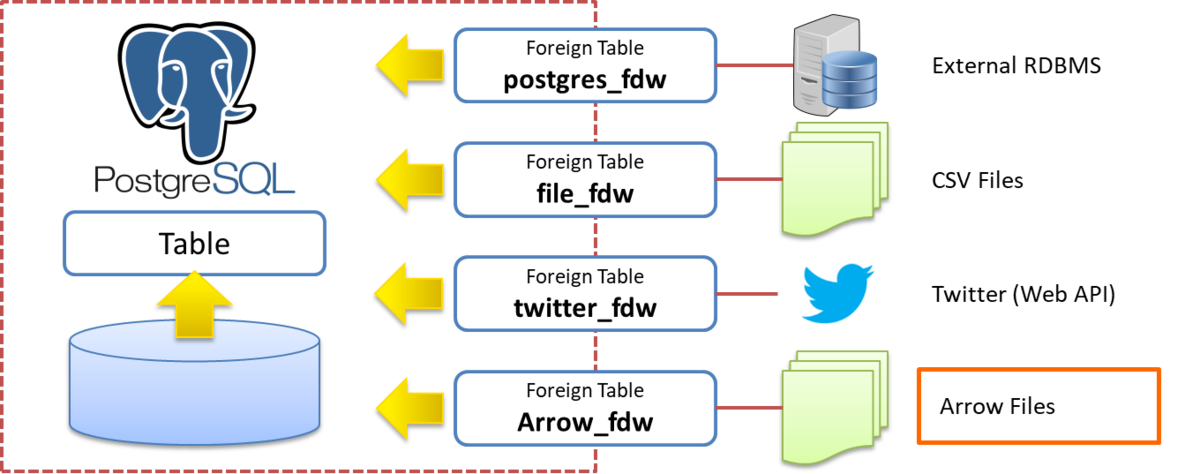

ただそれ以上に、PG-Stromのように『データが物理的にどこに存在するのか』を気にするソリューションだと更に大きな恩恵がある。

例えば、日々大量に溜まっていくログデータを、パーティション分割によって複数のディスクに物理的に分割格納し、集計・解析時にはこれを他のテーブルとJOIN/GROUP BYするという、比較的ありがちな処理を考えてみる。

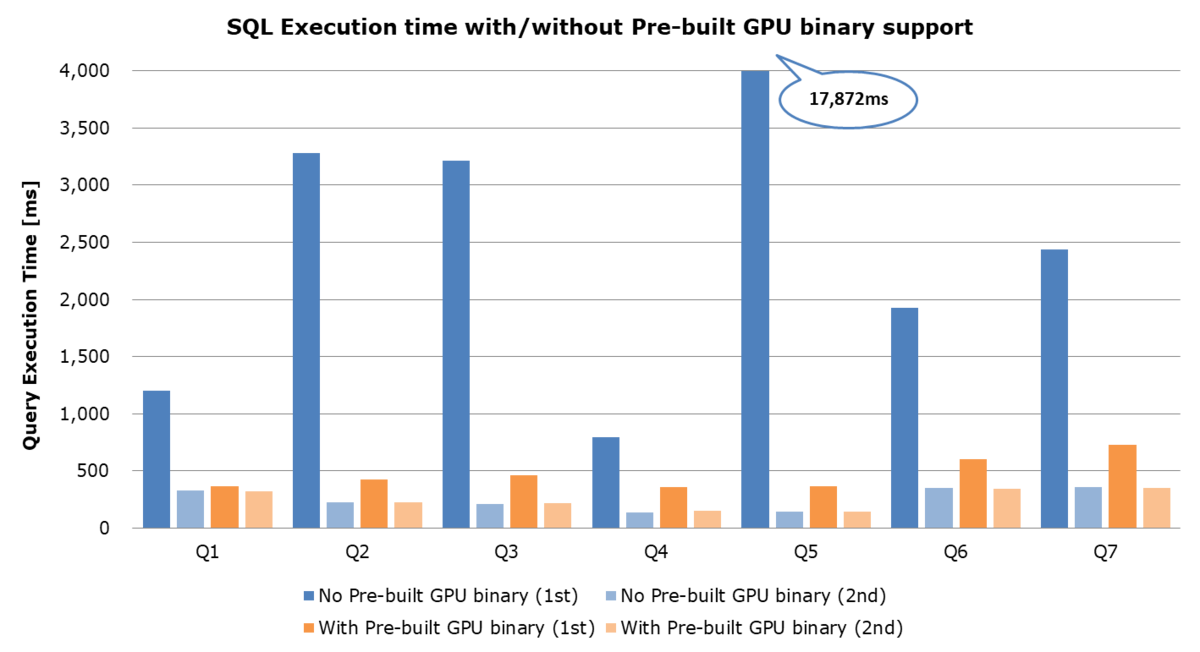

もし非パーティションテーブルとパーティションテーブルのJOINが必ずAppendの後であれば、SSD-to-GPU Direct SQLを使ったとしても、CPUが処理すべき行数はほとんど減ることはない*1ため、その後のJOIN/GROUP BY処理でGPUを使えたとしても、データの流れは Disk → CPU/RAM → GPU → CPU/RAM となってしまうため、データのピンポンによって転送効率はかなり悪化してしまう。

Asymmetric Partition-wise JOINによって、非パーティションテーブルとパーティション子テーブルのJOINを先に実行できるようになれば、これはSSD-to-GPU Direct SQLがフル稼働できる状況になり、データの流れも Disk → GPU → CPU/RAM とかなりシンプルになる。

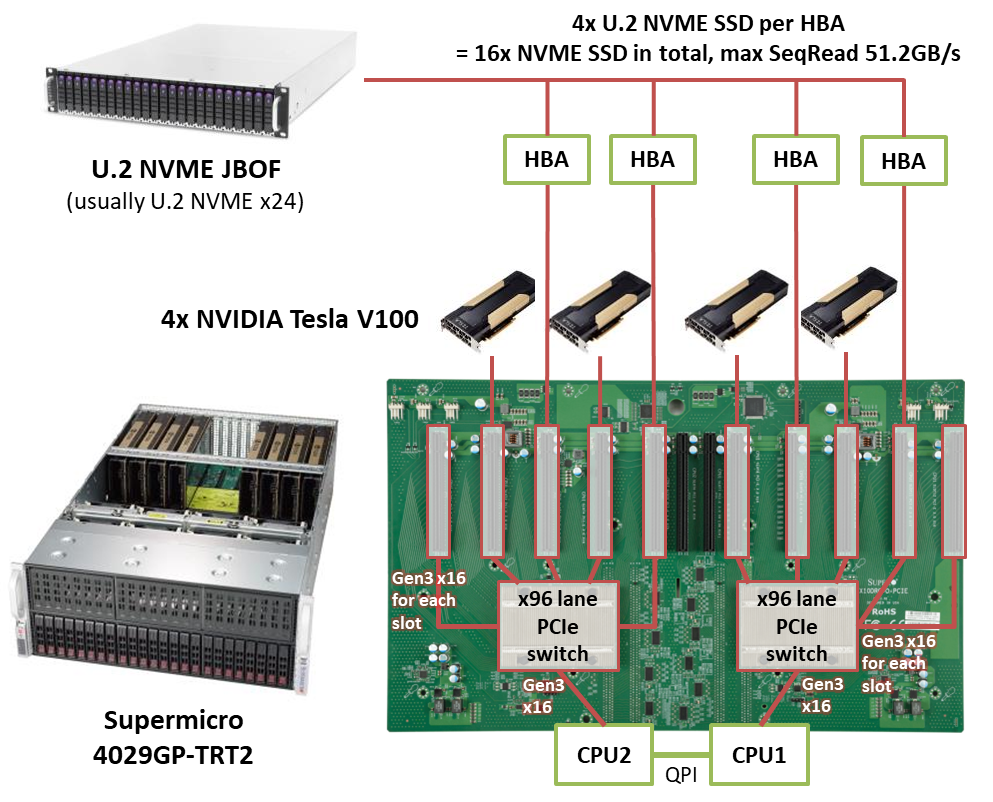

これはとりわけ、以下のような構成のマシンを用いてPCIeスイッチ経由でSSDとGPU間でのダイレクトデータ転送を行う場合に顕著で、SQLワークロードの大半をPCIeスイッチより外側のNVME-SSDとGPUのペアで実行する事ができるので、データが全くCPUを経由することなく処理されてしまう(= シングルノードでもPCIeバスの限界までスケールできる)という事になってしまう。

こういった諸々面白い事ができるようになるので、ぜひ皆さんにもCommitFestに登録されたパッチのレビューに参加していただければ幸いである。

*1:スキャン条件のみで大半の行を落とせるという幸運な場合を除く